-

Postów

163 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

11

Treść opublikowana przez First Ever

- Poprzednia

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- Dalej

-

Strona 5 z 7

-

Wydaje mi się, że to nadal za dużo... Oglądam YouTube w 4K z włączoną funkcją Super Resolution - Quality 4 (w panelu NVIDIA) i hotspot nie przekracz u mnie 40'C. Spróbuj to jeszcze raz zamontować bez termopadów na VRAM - dla szybkiego testu. Temperatura GPU hotspot szybko osiąga swoją maksymalną wartość, u mnie wystarczy 35 sekund by osiągnęło 91'C w teście AIDA64. Jeżeli bez termopadów na VRAM temperatura GPU spadnie, znaczy to, że masz za grube. I staraj się to testować w AIDA64 (Stress GPU) - wtedy będziesz wiedział jaka będzie możliwie najgorsza temperatura, bo w grach będzie dużo niższa. Update... Przyjrzałem się jeszcze raz zdjęciu i myślę, że docisk na GPU jest zdecydowanie za mały. Nie ma możliwości by przy odpowiednim docisku, na środku pozostawała taka duża ilość pasty, dodatkowo taka ilość spokojnie powinna się "wylać" na boki rdzenia. I nie ma tu znaczenia, że to zdjęcie z pierwszego zamontowania z punktową aplikacją - w takiej ilości pasta powinna się wylać na brzegi.

-

Nałożyłeś pastę jak na IHS (heat spreader) od CPU - tam to ma pewne uzasadnienie, bo rdzeń zawsze jest mniejszy i na środku. Ja nigdy nie patrzę na te głupkowate rady typu, zrób gluta, 5 glutów lub krzyżyk - to jest głupie bo zawsze może się coś nie rozprowadzić. Od 25 lat równo rozprowadzam (małą warstwę) pasty na cały IHS i zawsze miałem dobre temperatury, na GPU nie masz wyboru i TRZEBA całego posmarować 🙂

-

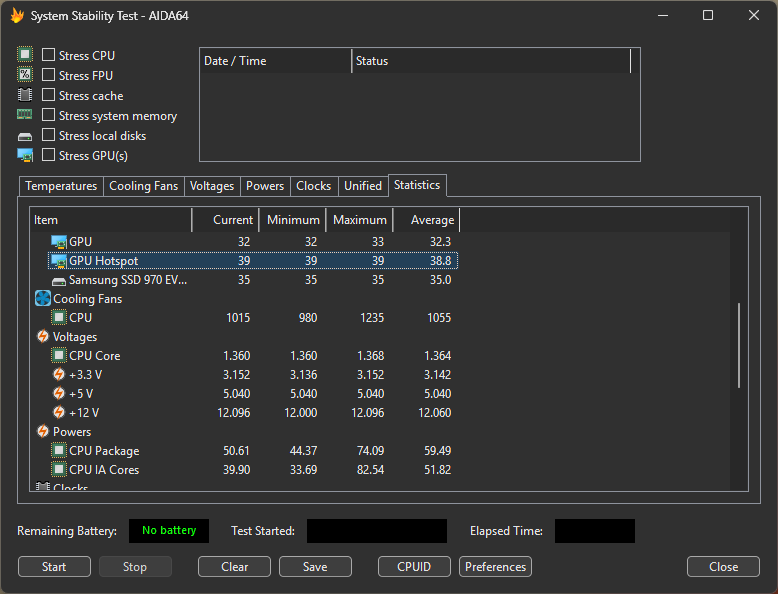

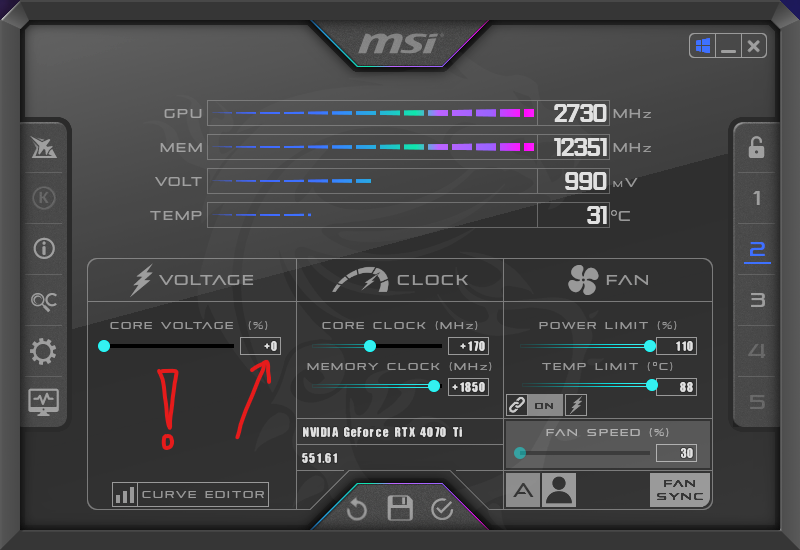

Test stabilności AIDA64 dużo bardziej obciąża GPU niż gry, a co za tym idzie w grze jest niższa temperatura i mniejszy hałas. Wychodzi na to, że zmiana napięcia tylko + 0.05V na RTX 4070 Ti powoduje wzrost GPU Hotspot aż o 19'C - bez jakiejkolwiek różnicy dla stabilności czy maksymalnego OC.

-

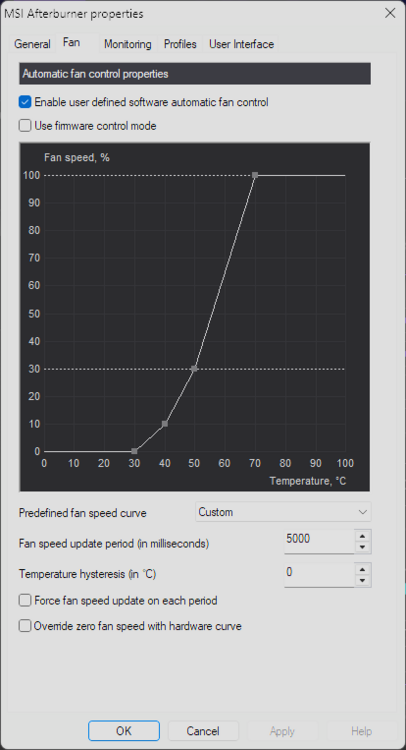

W pokoju mam 22'C, dobra obudowa 2x 200mm dmucha bezpośrednio na kartę od dołu + krzywa wentylatorów (patrz wcześniejszy screen)... możliwe. +180 na GPU okazało się nie stabilne po godzinie gry w Cyberpunk z RT, zchodzę do +170.

-

Sprawdziłem teraz w grach, z jeszcze wyższem OC +180MHz GPU w wbudowanym benchmarku Cyberpunk 2077 (Ray Tracing: Overdrive @ 4K) mam... GPU Core +0 / Power Limit 1100 / Fans Max przy 70'C): GPU 64'C / GPU Hotspot 82'C (jest dużo ciszej - chłodzenie karty działa na ok. 75%)

-

Mam obudowę CoolerMaster SL600M (do dzisiaj jedna z najepszych jeżeli chodzi o temperatury GPU) z 2x 200mm wentylatorami na spodzie, które bezpośrednio dmuchają na GPU. CPU nie jest w stanie tam pogrzać GPU, bo radiator jest na górze obudowy gdzie wylatuje powietrze (tunel). 110'C mam jak zwiększę napięcie 1.1V -> 1.15V 91'C przy tym samym OC bez zmiany napięcia Najbardzej w tym wszystkim interesuje mnie, czy zyskam cokolwiek wymieniając roczną stockową pastę ASUS-a na Kryonaut (chyba to zrobię, bo lubię takie eksperymenty).

-

Czyli się zgada mam 91'C, karta była kupiona dokładnie rok temu, więc chyba jest za wcześnie bo ją otwierać i oryginalna pasta powinna być nadal dobra. Mam też, Conductonaut (ciekły metal), ale pewnie odradzicie bym go urzywał na GPU 😛

-

Używam tej karty w komputerze na którym pracuję zdalnie, więc to odpada. Na stole leży już Kryonaut i samemu mogę to zrobić w 5 minut. Nie chcę zrywać naklejki, ale prawnie karta i tak pozostanie na gwarancji. To jaka powinna tam być temperatura na GPU hotspot na tej karcie?

-

Dzisiaj zaobserwowałem to na moim ASUS TUF RTX 4070 Ti OC. Po uruchomieniu testu stabilności GPU w AIDA64 GPU Hotspot skoczył prawie do 110'C i to po kilku sekundach, Dodam, że mam bardzo agresywnie ustawioną krzywą wentylatorów (max RPM przy 70'C) - oczywiście karta jest w idealnym stanie jak z pudełka (bez kurzu). Okazało się, że za tak wysoką temperaturę odpowiedzialny był OC (a wszystko było na max). Dlatego postanowiłem przetestować różne ustawienia po 2 minutach (temperatury już nie wzrastahą) testu w AIDA64. Bez OC (Stock): GPU 71'C / GPU Hotspot 91'C (cicho - chłodzenie na 59%) - wynik test Furmark ROG 1080 ROG: 388 FPS Max OC stabilne w Cyberpunk 2077 dla mojej karty to +160MHz na GPU i +1850MHz na MEM. GPU Core +100 / Power Limit 110 / Fans Max): GPU 82'C / GPU Hotspot 110'C (głośno - chłodzenie na 100%) - wynik test Furmark ROG 1080 ROG: 393 FPS GPU Core +100 / Power Limit 100 / Fans Max): GPU 79'C / GPU Hotspot 104'C (głośno - chłodzenie na 100%) - wynik test Furmark ROG 1080 ROG: 398 FPS GPU Core +0 / Power Limit 1100 / Fans Max): GPU 69'C / GPU Hotspot 91'C (głośno - chłodzenie na 100%) - wynik test Furmark ROG 1080 ROG: 399 FPS Teraz zastanawiam się czy 90'C na GPU Hotspot to dużo czy norma dla tej karty (bo chłodzenie ma porządne). Jeżeli ktoś z was posiada RTX 4070 Ti i mógłby to szybko sprawdzić w AIDA64 i podesłać wyniki to byłbym wdzięczny. Wydaje mi się, że może to być normalna temperatura, i najlepiej nie ruszać suwaka z napięciem (bo u mnie i tak nie ma to wpływu na stabilność karty vs max OC). Pewnie powiecie, że nie warto podkręcać tej karty dla niecałych 3% (Furmark), ale w 4K w Cyberpunk wychodzi już 11% (+7 FPS w 4K i Ray Tracing: Overdrive), więc warto.

-

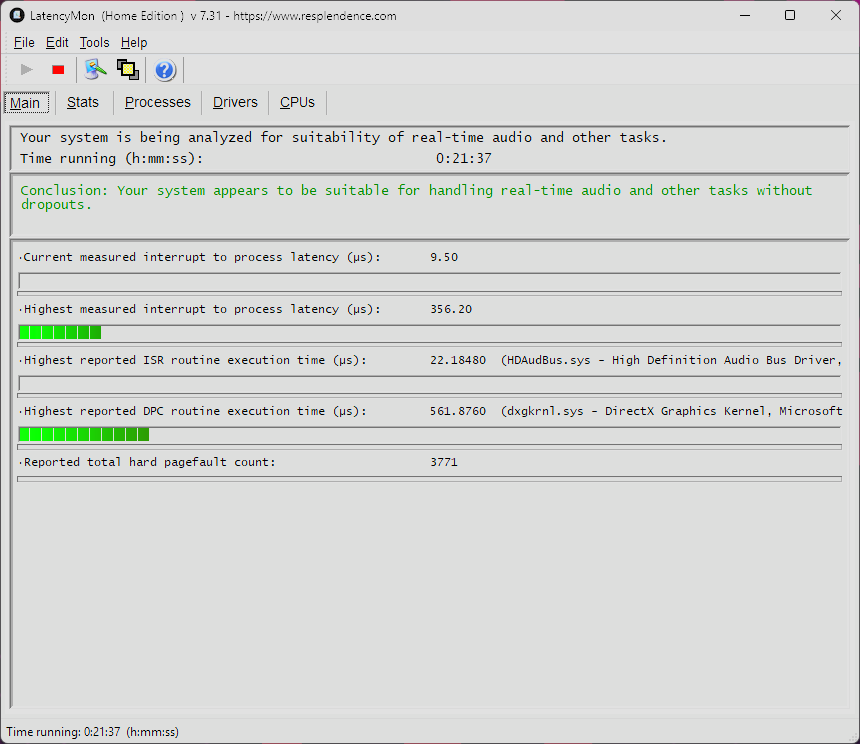

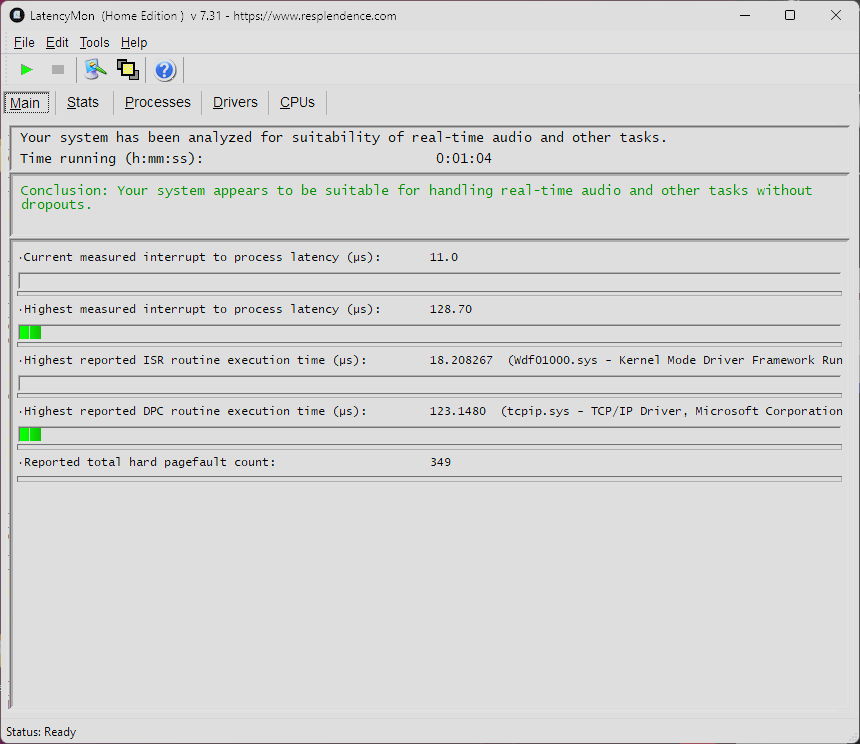

Windows i szybki test w LatencyMon

First Ever odpowiedział(a) na First Ever temat w Microsoft Windows

-

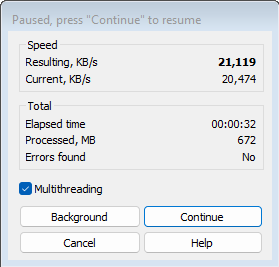

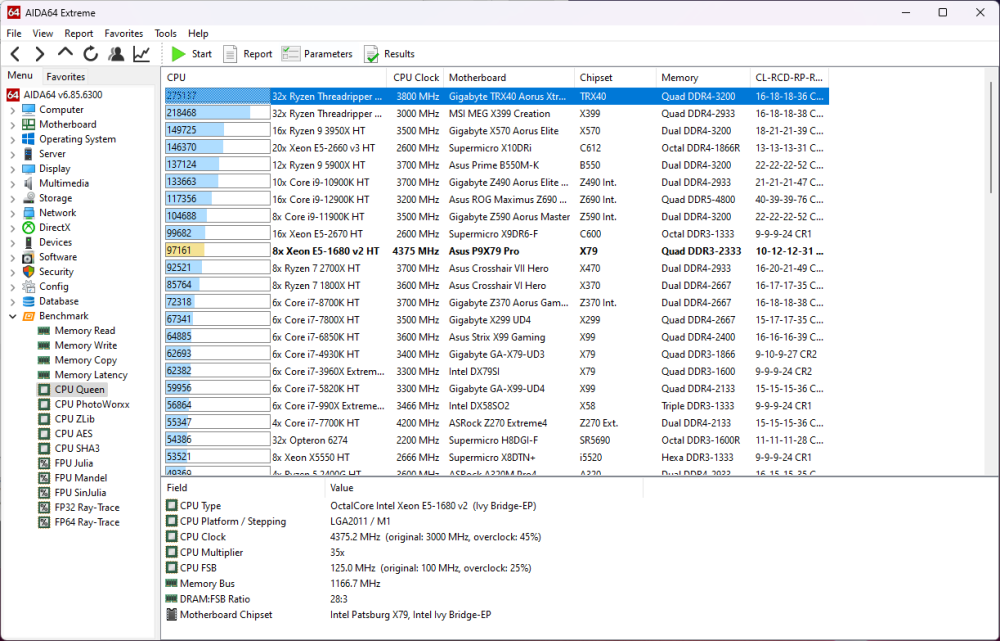

Właśnie zaktualizowałem system Windows 11 do najnowszego builda 26040 (Insider Preview) i działa on zaskakująco szybko, dlatego postanowiłem sprawdzić co pokazuje LatencyMon v7.31 Szybko o programie LatencyMon: Najnowszą darmową wersję (Home Edition) 7.31 można pobrać używając tego linku. Używam "trupa" z Xeon E5-1680 v2, 32GB Quad DDR3 2400 i RTX 4070 Ti, wszystko maksymalnie podkręcone i zoptymalizowane. Jak testować - urchamiamy LatencyMon i zostawiamy pomiar na co najmniej 60 sekund a następnie zatrzymujemy. Oczywiście używam normalnego systemu Windows (nie jakiegoś kastrata), i mam całkiem dużą ilość softu uruchomionego w tle. Wydaje mi się, że będziecie mieć problem by zbliżyć się do opóźnienia jakie uzyskałem na tej 13-letniej maszynie.

-

Asus DSL-AC68U vs Asus DSL-AC88U

First Ever odpowiedział(a) na VonV3in temat w Sprzęt Sieciowy, Wi-Fi

Zmiana studni na pustyni nie spowoduje, że pojawi się w niej woda... -

Prawda o WiFi 7 - przeczytaj zanim przepłacisz...

First Ever opublikował(a) temat w Sprzęt Sieciowy, Wi-Fi

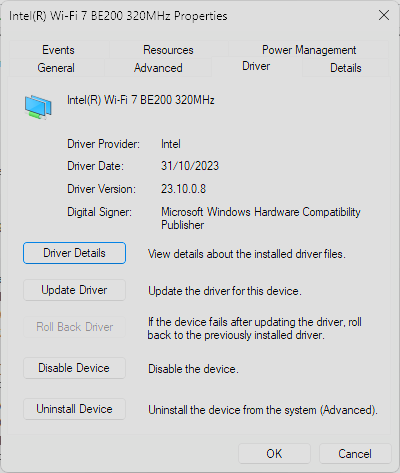

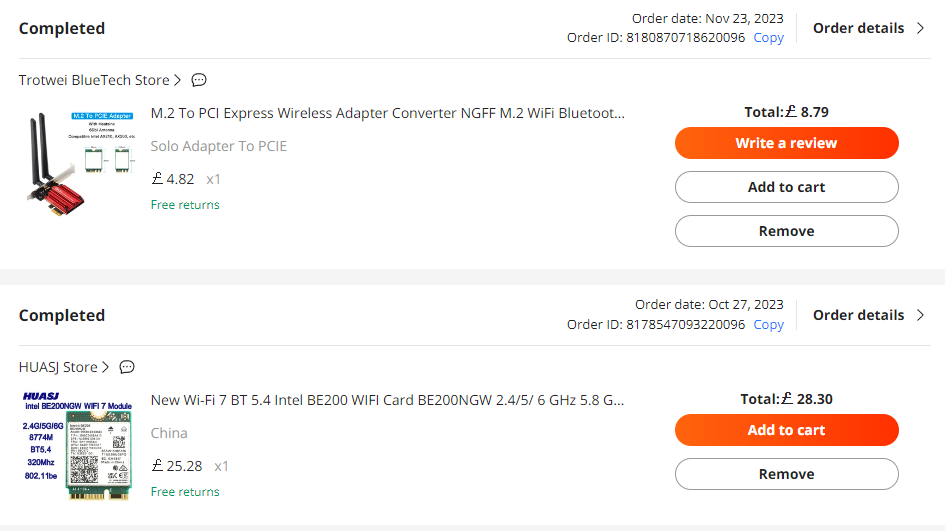

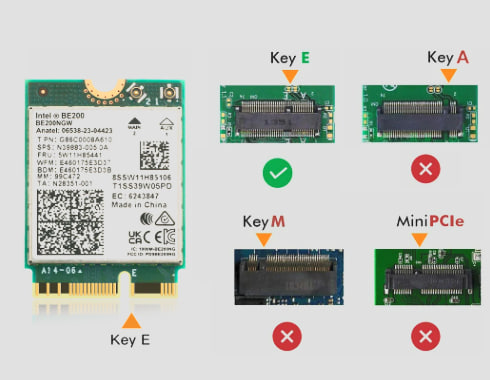

WiFi 7 nie zostało jeszcze zatwierdzona przez WFA (Wi-Fi Alliance), a producenci sprzętu tacy jak Intel lub Qualcomm już od miesięcy tworzą karty z chipami WiFi 7. Link: https://www.intel.com/content/www/us/en/products/sku/230078/intel-wifi-7-be200/specifications.html Microsoft nawet dał certyfikat do sterowników, do sprzętu który jeszcze nie przeszedł certyfikacji - fajnie! 🙂 Tak wyglądają prędkości - zacnie! Nie będę się rozpisywał, bo powyższe numerki mówią same za siebie, ale i tak mało kto ma w domu łącze o prędkości 1 Gbps, więc teoretycznie nie potrzebyjemy szybszych routerów. Nie zmienia to faktu, że zamontowałem chyba jako pierwszy na świecie (w końcu First Ever) kartę WiFi 7 z BT 5.4 w moim 12 letnim komputerze 😄 Tutaj macie specyfikację mojego kompa (obecnie wsadziłem w niego jeszcze Samsung 990 Pro 4TB i RTX 4070 Ti), a czemu nie... Cała "inwestycja" zamyka się w kwocie £37 (185 PLN po obecnym kursie). Posiadam router WiFi 6E, więc prędkość połączenia to nadal 2400 Mbps... ale już na paśmie 6GHz (wcześniej miałem identyczną prędkość na 5GHz / karta WiFi 6). I na koniec słowo do producentów np. ASUS - możecie mnie pocałować w ****! Za kilka miesięcy stworzą własne karty WiFi (tak na prawdę to adapter z radiatorem i antenki), a w środku będzie ta sama karta Intel BE200 w premium cenie x3! Rada 1: Nie kupujcie kart Intel BE202 - pomimo wyższego numeru nie obsługuje częstotliwoąci 320MHz, tylko 160MHz), jedynie BE200 obsługuje 320MHz. Link do karty: https://www.aliexpress.com/item/1005006174165072.html Rada 2: Wystarczy, że posiadacie wolny slot PCIe 3.0 x1 (nie testowałem na starszych gen) i adapter ze złączem Key E! Tutaj link do adaptera który kupiłem, nawet chińczycy nie wspominali o kompatybilności z WiFi 7, ale zadziałało! https://www.aliexpress.com/item/1005005949141881.html Rada 3: Windows 11 nie potrafi znaleźć sterownika do kart BE200/BE202, więc trzeba go ręcznie zainstalować. Sterownik można pobrać ze strony Intela: https://www.intel.com/content/www/us/en/download/19351/windows-10-and-windows-11-wi-fi-drivers-for-intel-wireless-adapters.html -

Tu nie chodzi o gwarancję, ale o fakt jak ta firma ma wszystkich głęboko w ****. Kupiłem od nich 3 produkty powyżej £1000 i w przypadku problemu traktują ludzi jak śmieci... Pro WS WRX80E-SAGE SE WIFI - początkowy BIOS po restarcie komputera uwalał całkowicie płytę, pomagał tylko reflash BIOS'a - ASUS nie odpisał na moje zgłoszenia w UK i PL supporcie. ASUS RTX 3070 Ti TUF - laminat zaczął się sam wyginać (zamieściłem zdjęcia). Karta nie miała dołączonego wspornika, co im zasugerowałem - nie odpisali. ROG Swift OLED PG48UQ - jakiś "niedowidzący" tworzy firmware do ich topowych monitorów, a oni wrzucają je na swoją oficnalną stronę.

-

W największym skrócie, zabawę z Ray-Tracing powinno się rozpoczynać na kartach RTX 4070. Kolejną rzeczą jest rozdzielczość monitorów, dla 1080p/1440p wybrałbym RTX4060Ti z 8GB, natomiast do 4K wybrałbym RX6800 z 16GB.

-

Cześć, Nie wierzę, że jakikolwiek Polski portal ma jaja by zadzierać z ASUS'em i napisać o nich negatywneto newsa, bo pewnie zostaniecie pominięci przy dostawie nowego sprzętu do testów. Podobno w Europie jest wolność słowa, więc mogę napisać co myślę o tej firmie na ogólnodostępnym forum... Wyobraźcie sobie, że kupiliście topowy gamingowy monitor za £1500 (co prawda z zeszłego roku, ale jest nadal w sprzedaży) i producent (ASUS) wypuszcza do niego firmware "naprawiające tryb HDR". Wcześniej było inne "ciekawe" firmware, które bez wiedzy i zgody użytkownika włączało opcję "Pixel Cleaning" czyli monitor robił się czarny na około 3-5 minut np. gdy graliście lub pracowaliście, albo kolejene które nie potrafilo włączyć monitor po przejściu w tryb uśpienia - GENIALNE! A teraz zobaczcie co jak przed świętami "naprawili" tryb HDR! Tutaj wątek na oficjalnym forum ASUS: https://rog-forum.asus.com/t5/gaming-monitors/pg48uq-firmware-v29-awful-hdr/td-p/975749?lightbox-message-images-977227=84236i7330E66E6851D379 ZAŁOŻYŁEM SIĘ O £1000, ŻE ŻADEN Z PROCOWNIKÓW ASUS NIE PRZETESTOWAŁ TEGO FIRMWARE NA ŻADNYM MATERIALE HDR! Obecnie cała strona supportu do tego modelu po prostu zniknęła, jak ktoś zaktualizował firmware do wersji V029 i nie posiada starszej to ma problem (dlatego sam go udostępniłem na stwom hostingu). Jakby ktoś potrzebował zrobić downgrade to tutaj jest plik do firmware V028: ASUS_PG48UQ_FW_V028_and_update_SOP.zip Oni są niepoważni, taka duża firma powinna być w stanie szybko usunąć "wadliwe" firmware z ich stron a nie wyłączać całą stronę supportu dla jakiegoś produktu! ASUS zmienił link by nie można było znaleźć strony supportu: https://rog.asus.com/uk/undefined/above-34-inches/rog-swift-oled-pg48uq-model/helpdesk/ Oczywiście poprwany link nadal działa i można go otworzyć: https://rog.asus.com/uk/monitors/above-34-inches/rog-swift-oled-pg48uq-model/helpdesk/ A na koniec zobaczcie jak wygląda ich udoskonalony HDR (bez względu na ustawienia w Windows, czy ustawienia w monitorze, zawsze wygląda tak samo "pięknie"). Moje podsumowanie firmy ASUS (kiedyś mojej ulubionej firmy): Hardware Design: 9/10 Software/Firmware: 4/10 Support: 0/10 (nie istnieje)

-

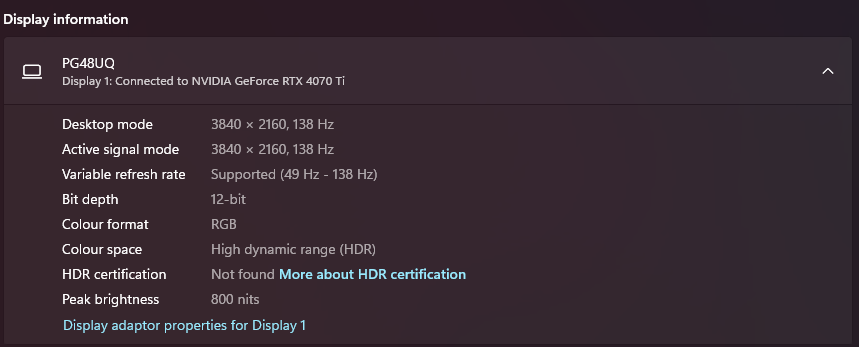

Wymieniłem monitor na "zeszłorocznego" ASUS'a i trochę się nim bawiłem... Oczywiście kupiłem jakiś przyzwoity kabel DisplayPort 8K @ 60FPS (32.4Gbps): Amazon Link Monitor pracuje w natywnej rozdzielczości 4K (3840x2160) z aktywowanym trybem OC 120->138Hz, włączony HDR i 10-bitowy kolor, głębokość 32-bit i pełnym zakresie. Jakie było moje zdziwienie,gdy udało mi się włączyć 12-bitowy kolor, pozostałe parametru pozostały bez zmiany. Tak wygląda rozpiska z ilością kolorów: 8-Bit: 16.7 Million Colors (256 Colors Per Channel) 10-Bit: 1.07 Billion Colors (1024 Colors Per Channel) 12-Bit: 68 Billion Colors (4096 Colors Per Channel) Poszukałem jak obliczyć przepustowość kabla DisplayPort: For example, for 3840 × 2160 @ 60 Hz 8 bpc RGB color: H = 3840 px V = 2160 px C = 24 bit/px (8 bits per channel × 3 channels: R, G, and B) F = 60 Hz Hblank = 560 (obtained from CTA-861 standard) Vblank = 90 (obtained from CTA-861 standard) Required data rate = (3840 + 560) × (2160 + 90) × 24 × 60 = 4400 × 2250 × 24 × 60 = 14,256,000,000 bit/s = 14.26 Gbit/s Według powyższego wzoru: ROG PG48UQ, for 3840 × 2160 @ 138 Hz 12 bpc RGB color: H = 3840 px V = 2160 px C = 32 bit/px (12 bits per channel × 3 channels: R, G, and B) F = 138 Hz Hblank = 560 (obtained from CTA-861 standard) Vblank = 90 (obtained from CTA-861 standard) Required data rate = (3840 + 560) × (2160 + 90) × 32 × 138 = 4400 × 2250 × 32 × 138 = 43,718,400,000 bit/s = 43.72 Gbit/s Na koniec, tak wyglądają oficjalne przepustowości DisplayPort 1.4 vs 2.0: DP 1.4 High Bit Rate (HBR) 10.8 Gbps 4K@30Hz High Bit Rate 2 (HBR2) 17.28 Gbps 4K@60Hz High Bit Rate 3 (HBR3) 25.92 Gbps 4K120Hz 8K@60Hz with DSC High Bit Rate 3 (HBR3) 32.4 Gbps 8K@60Hz 5K@60Hz 4K@240Hz 2K@240Hz DP 2.0 Ultra High Bit Rate UHBR 10 (4 x 10 = 40Gbps) Ultra High Bit Rate UHBR 13.5 (4 x 13.5 = 54Gbps) Ultra High Bit Rate UHBR 20 (4 x 20 = 80Gbps) Jakim sposobem DisplayPort 1.4, który ma przepustowość 32.4 Gbps działa przy 43.72 Gbps? EDIT #1: Znalazłem (sam sobie odpowiem), w monitorze aktywowana jest funkcja DSP (Display Stream Compression). Po wyłączeniu DSC odświeżanie spada do 4K@60Hz, ale nadal można używać 12-bitowego koloru (dlaczego ASUS nie pisze o tym w specyfikacji tego monitora?) EDIT #2: Wychodzi na to, że nie ma znaczenia czy wybierzemy 10-bit czy 12-bit, bo człowiek nie jest w stanie zobaczyć różnicy...

-

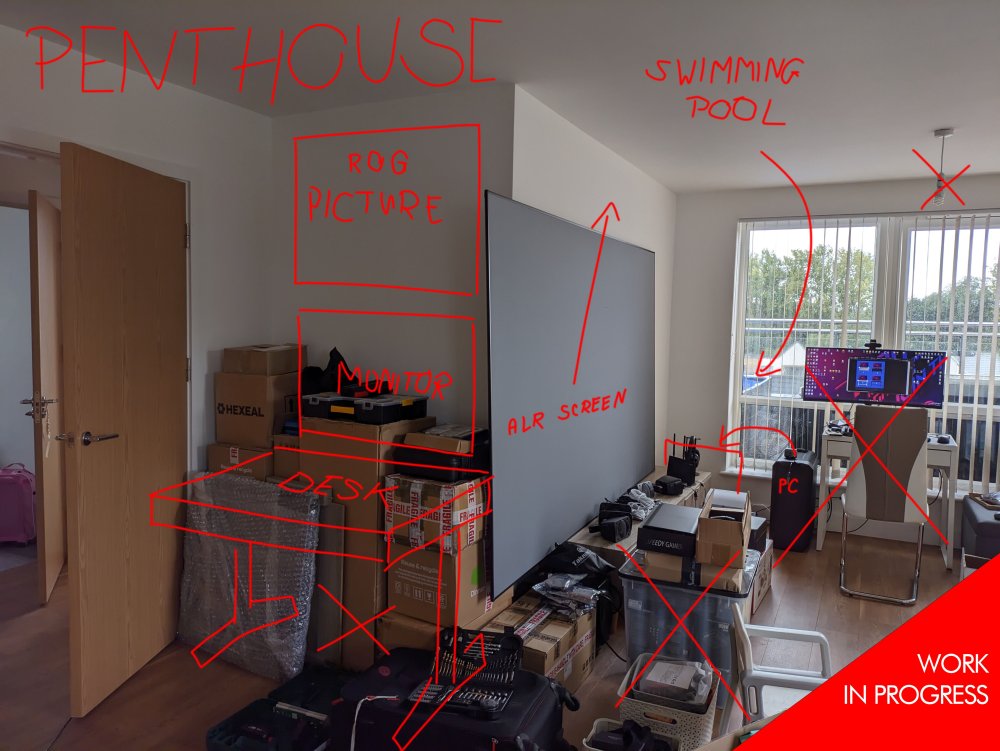

Buduję battlestation... stanowisko pod PC.

First Ever odpowiedział(a) na First Ever temat w Co kupić?

UPDATE Po 1 dniu planowania i 2 dniach na dostawy kurierskie oraz 1 noc na złożenie wszystkiego. Przemyślenia... Te biurko wygląda fajnie i przy cenie £300 wydaje się być ok... ale, ten kto je projektował chyba nie słyszał o ramieniach do monitorów (nieakceptowalne). Blat ma grubość tylko 12mm (zaszaleli), ale wraz z metalową konstrukcją szerokość biurka wynosi 56mm i jest stabilny - chociaż nie mam zamiaru na niego wchodzić, bo producent określa maksymalny udźwig do 50kg. Wracając do ramienia - prawdopodobnie żadne ramię o dużym udźwigu dostępne na runku nie będzie "kompatybilne" z tym biurkiem, ponieważ dokręca się je nie na rancie a trochę wewnątrz (a tam biurko już nie ma grubości trzeba coś podłożyć). Z godzinę (piłowałem dechy z jakiegoś starego łóżka by je tam podłożyć, ostatecznie się udało). Gdyby nie ten mankament dałbym 8.5/10, a tak daję 4/10 - co za debil to projektował, wystarczyło dodać do zestawu twardy kawałek deski o wymiarach 100x50x41mm i byłoby po problemie. Poza tym blat ma jakąś dziwną okleinę która masakrycznie łapie odciski palców. Szuflada jest otwierana w głupoowaty sposób, trzeba ją mocna złapać i pociągnąć (a nie ma za co). Nie mam zastrzeżeń do pracy biurka - zmiana regulacji działa sprawnie i cicho. Sprzedałem 2 stare zbędne monitory i upgrade do tego ASUS-a wyniósł £330. Używany w idealnym stanie i z gwarancją, problem było znalezienie kuriera który by to przewiózł w UK (wszyscy 95% odmawiają udzielenie ubezpieczenia na przewóz takiego sprzętu o takich gabarytach - udało się z FedEx). Po podłączeniu porządnym kablem DP 8K o długości 5m wszystko działa tak jak powinno, tzn. 4K@138Hz z HDR i 10bitowy kolor. Okazało się, że coś jest nie tak z dźwiękiem (statyczny szum jak cewki w niektórych kartach graficznych pod obciążeniem, ale 5x głośniejszy - po aktualizacji firmware monitora do wersji V028 problem zniknął). Ogólnie jestem bardzo zadowolony, a wszystko co zaplanowałem pokryło się w 95% z rzeczywistością: Trzeba było robić modyfikację biurka pod ramię do monitora - stworzyć podkładkę. Na projekcie ramię zamontowane jest z lewej strony co wymagało kabla dłuższego o 2m (ok. 7m), więc zamontowałem z prawej strony. Pad przesunąłem do prawej strony, mam większą powierzchnię pod myszką a z lewej strony miejsce na słuchawki (wizualnie jest ok). Wcześniej miałem problem z podłączeniem kamerki Logitech Brio dłuższymi kablami, i w rozdzielczości 4K pojawiały się artefakty lub się rozłączała, ale obecnie wszystko działa ok. Pozostało mi poukładanie kabli i przemyśleć co z nimi zrobić gdy będę chciał podnieść biurkow do góry i pracować na stojąco... Zmiana z 3440x1440 na 3840x2160 dała trochę popalić RTX 4070 Ti. Gram w 4K więc największy wpływ na wydajność ma GPU (trzeba będzie pomyśleć o upgrade do RTX 5000?) JEŻELI BUDUJECIE COŚ PODOBNEGO (DUŻEGO) TO NIE SKŁADAJCIE TEGO SAMI - JEDNO STUKNIĘCIE I BĘDZIE PO ZABAWIE. NIE WIEM JAKIM SPOSOBEM UDAŁO MI SIĘ ZAMONTOWAĆ TO W POJEDYNKĘ (A MUSIAŁEM 3 RAZY POPRAWIAĆ). Może za jakiś czas zamontuję 400-strefowe podświetlanie, które stworzyłem pod mojego wcześniejszego 40-calowego Philipsa, powinno pasować... Pozdrawiam- 3 odpowiedzi

-

- 1

-

-

- battlestations

- biurko

-

(i 2 więcej)

Oznaczone tagami:

-

Buduję battlestation... stanowisko pod PC.

First Ever odpowiedział(a) na First Ever temat w Co kupić?

Ogólnie cena £890 to trochę dużo i te ich logo jest dla mnie nie do zaakceptowania (ciekawe czy dołączają naklejkę na czoło). Lubię 'Old Skool', czyli nie RGB, a minimalizm i jakiś sensowny motyw - w tym przypadku będzie to ASUS ROG. Śmieszne jest to, że posiadam tylko monitor z tej serii, ale mam płytę główną i kartę graficzną ASUS'a. Wracając do tematu - wybrałem opcję 4, bo nie podobały mi się dziury w blacie w opcji 1 i 2. Nigdzie nie mogę znaleźć specyfikacji portów USB jakie używają w tym FLEXISPOT Comhar EW8B - to są USB tylko do ładowania? Jeżeli to jest do danych, to kolor portów nie wróży dobrze... będę pewnie to modyfikował pod USB 3.2 Gen2. Jak już wszystko poskładam i posprzątam to pokażę efekt końcowy...- 3 odpowiedzi

-

- battlestations

- biurko

-

(i 2 więcej)

Oznaczone tagami:

-

48 calowy OLED od ASUSa dojdzie do mnie w środę, więc muszę dzisiaj zamówić biurko, bo nie chcę go później używać na podłodze. Od razu zaszaleję i stworzę sobie motyw graficzny ASUS ROG - tapeta oraz mouse pad pozostają i nie podlegą dyskusji. ASUS ROG podkładka 90x30cm: https://www.amazon.co.uk/gp/product/B08BWXM9Z7/ (cena z d***) Biurko opcja 1: standardowe (białe lub czarne): https://www.amazon.co.uk/dp/B09TD9D7TK/ Biurko opcja 2: automatyczne (białe lub czarne): https://www.amazon.co.uk/dp/B08PFH81J6/ Zrobiłem szybką wizualizacje - wymiary są zachowane (podkładka wejdzie na milimetry między otwory na kable w biurku 1), opcja 2 jest 2x droższa. Na podkładcę będzie klawiatura i mysz Logitecha (z odpowiednim motywem podświetlenia), nie dodawałem do wizualizacji (nie mam czasu). Znalazłem ramię które utrzyma monitor o wadze do 18KG (ten ASUS ma 15KG): https://www.amazon.co.uk/gp/product/B08RS2SD4T Jest podobne w kolorze białym (ale droższe o kolejne £20): https://www.amazon.co.uk/dp/B0BCJG24BF/ Białe ramię może być ciekawe jeżeli wybiorę białe biurko... Przygotowałem 4 propozycje... Kupuję też nowe krzesło i też będę musiał zdecydować czy czarne czy białe.... (do zestawu). Biurko (nie regulowane, wydaje mi się solidniejsze), wytrzyma udźwik 80kg, natomiast to elektryczne tylko 50kg. Z drugiej strony kompletnie nie podobają mi się wycięcia pod kable w blacie w biurku nr. 1. Co byście wybrali... w środę mogę zamieścić zdjęcia działającego zestawu...

- 3 odpowiedzi

-

- battlestations

- biurko

-

(i 2 więcej)

Oznaczone tagami:

-

NVIDIA GeForce Game Ready Driver 550.09 - tylko u mnie!

First Ever odpowiedział(a) na First Ever temat w Sterowniki, BIOS, UEFI

Znalazłem na necie, że np. działa RTX super resolution (opcja pojawia się w Panelu NVIDII) na RTX 2060S. -

NVIDIA GeForce Game Ready Driver 550.09 - tylko u mnie!

First Ever opublikował(a) temat w Sterowniki, BIOS, UEFI

Nie wiem ile mój serwer wytrzyma, ale się okaże... plik ma wielkość 775MB - VirusTotal (0/90) Link: https://firstever.eu/download/550.09-desktop-win10-win11-64bit-international-nsd-dch-whql.exe -

GeekBench 6 - zakłamany pseudo-benchmark!

First Ever odpowiedział(a) na First Ever temat w Oprogramowanie

Jeżeli jakaś firma tworzy program testujący wydajność sprzętu (płatny), to wyniki powinny się zgadzać. Z pewnością mają ogromną bazę porównawczą, ale wyniki nie mają sensu... tak jakby im M$ posmarował, by zaniżali wyniki starszych konstrukcji (w oczywistym celu - ludzie kupujcie najnowsze PC bo wam Winda nie zadziała). -

GeekBench 6 - zakłamany pseudo-benchmark!

First Ever odpowiedział(a) na First Ever temat w Oprogramowanie

Ano ja, a kto pyta? 🙂 -

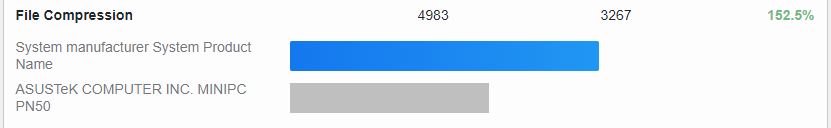

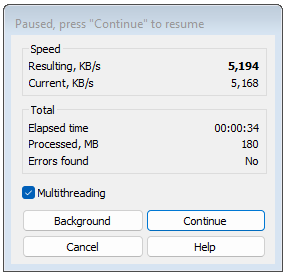

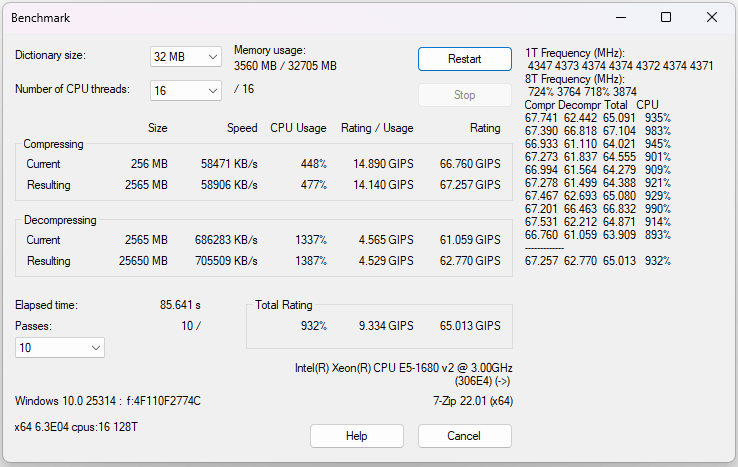

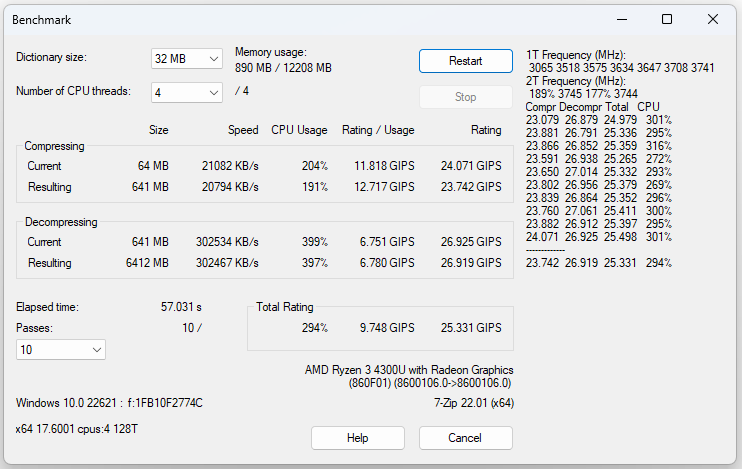

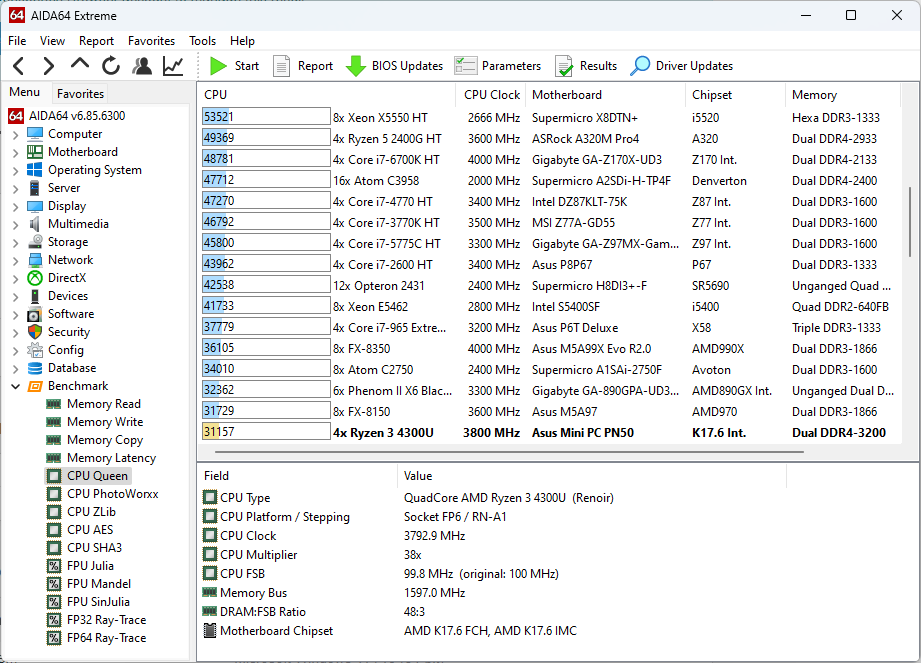

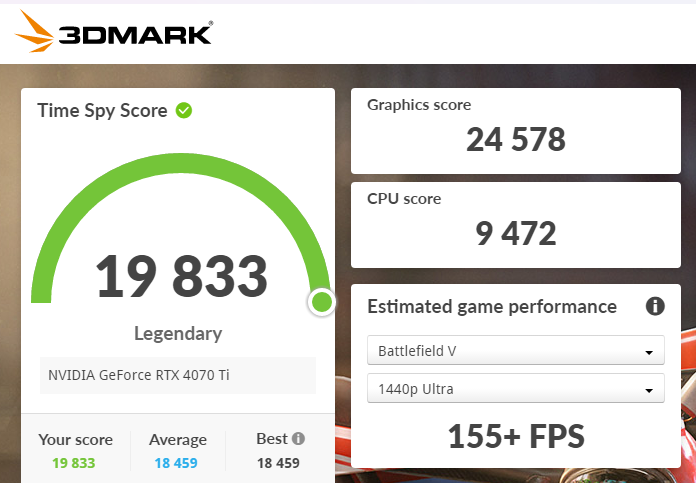

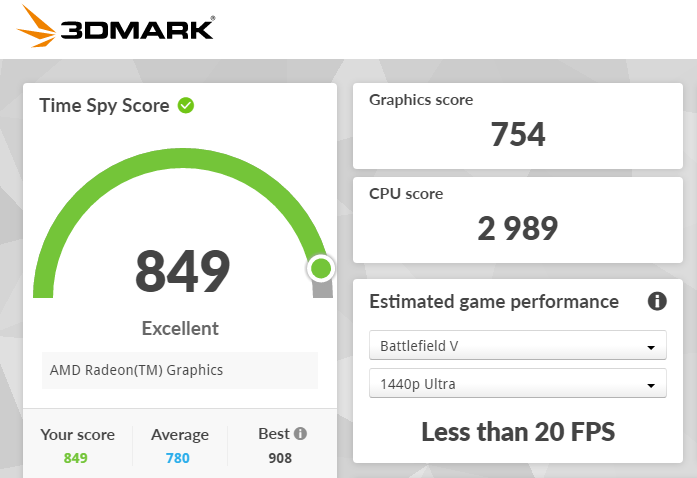

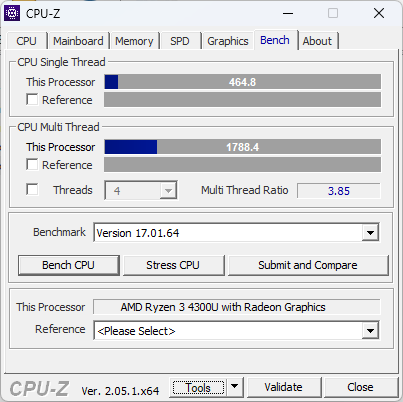

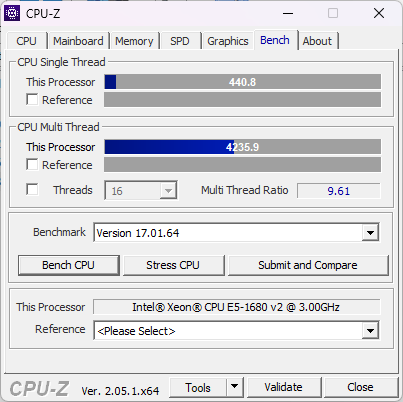

Większość ludzi, którzy wrzucają w sieć przedpremierowe wyniki wydajności używają programu GeekBench - ciekawe dlaczego? Dzisiaj zainstalowałem najnowszą wersję 6.0.1 a uzyskane wyniki to jakaś parodia / abstrakcja / zakrzywienie rzeczywistości (wybierzcie co chcecie). Zdjecydowanie więcej już tego nie zainstaluję! Pewnie powiecie, że porównuję 12-letnią platformę Intela do 3-letniej platformy AMD i dlatego wydajność jest zbliżona. Udowodnię, że równie dobrze moglibyśmy rzucać kostką i zapisać to jako wynik GeekBench. Najpierw zerknijmy na specyfikację obu komputerów. Na starym, ale nadal wydajnym komputerze z 8 rdzeniami i 16 wątkami, uzyskuję "aż" 119% w stosunku do niskonapięciowym Ryzen 3 4300U z 4 rdzeniami. Link: TUTAJ. To teraz zerknijmy na szczegółowe test: Według GeekBench 8-rdzeniowy/16-wątkowy procesor uzyskał 152.5% wydajności 4-rdzeniowego/4-wątkowego procesora w teście kompresji. Poniżej prezentuję wyniki z wbudowanych benchmarków z najpopularniejszych programów do kompresji WinRAR i 7-Zip. W realnym benchmarku wychodzi 406.6% (a nie 152.5%) na korzyść starej platformy z większą ilością rdzeni/wątków. Ale powiecie, że jeden test niczego nie zmienia, to dodajmy kolejny z 7-Zip... Wbudowany benchmark 7-Zip oblicza średnią wyników kompresji/dekompresji z 10 prób tj. 63.909 kontra 25.498. Czyli stara platforma Intela uzyskuje 250.64% (a nie 152.5%). To może porówajmy wyniki w benchmarku AIDA64. Czy to możliwe by 8R/16W stary CPU uzyskiwał 119% wydajności nowego 4R/4W CPU? Odpowiedź - NIE. Stary Intel uzyskuje 97161, a nowszy AMD 31157 i przekłąda się to na 311.8% wydajności. Kolejny test - wydajność CPU w 3DMark Time Spy (test CPU). W tym benchmarku stary Intel uzyskuje 9472, a nowszy AMD 2989 punktów, co przekłada się na 316.8% (a nie 118% jak "wyliczył" GeekBench). Na koniec wbudowany test w programie CPU-Z. Wyniki z tego programu też pojawia się w przedpremierowych testach nowych procesorów. Stary (podkręcony) Intel ma zbliżoną wydajność jednowątkową do nowszego AMD tj. 440.8 kontra 464.8. Jednak gdy mówimy o pełnej wydajności to wyniki mówią same za siebie 4235.9 kontra 1788.4 punktów. Dobijam ostatni gwóźdź do trumny pseudo-benchmarku GeekBench, to nie jest 119%, a 236.8%. Krótkie podsumowanie - nie wiem co oni tam testują, ale... GeekBench = Gów**Bench

- Poprzednia

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- Dalej

-

Strona 5 z 7